DataCore Software, fornitore leader di SAN virtuali iper-convergenti, Software-Defined Storage e software per l’elaborazione parallela dell’I/O, ha annunciato la nomina di Carrie Reber a Vice President of Worldwide Marketing.

Reber sarà responsabile delle attività di vendita e canale.Ben conosciuta come professionista di marketing e comunicazione nel settore della tecnologia, ha una vasta esperienza nella realizzazione e nella guida di strutture di marketing, nello sviluppo e nella gestione di piani strategici di posizionamento e comunicazione, nonché nel lancio di aziende software B2B innovative.

Con oltre 20 anni di esperienza nel settore tecnologico, Reber è stata recentemente vicepresidente di Datto con la responsabilità del marketing internazionale. In precedenza ha svolto funzioni dirigenziali in Infinio e ha realizzato la struttura di marketing gestendo le iniziative di go-to-market a supporto della rapida crescita di Veaam, partita come startup e arrivata a 100 milioni di dollari di fatturato.

Precedentemente, Reber è stata Director of Product Public Relations and Analyst Relations di Quest Software e ha lavorato in strutture di marketing di diverse aziende, tra cui Aelita Software, Legent Corp. e CompuServe.

Con la tecnologia Parallel I/O di DataCore che continua a ottenere risultati record nelle prestazioni e nel rapporto prezzo/prestazioni con le soluzioni Hyper-converged Virtual SAN e SANsymphony Software-Defined Storage, l’azienda ha registrato una crescita a doppia cifra in regioni chiave come le Americhe, l’EMEA e l’APAC.

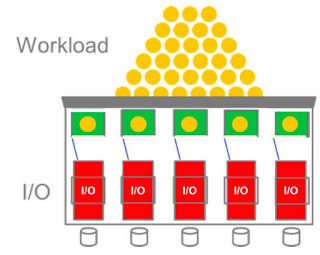

Una delle principali responsabilità di Reber sarà quella di continuare a rafforzare la riconoscibilità del marchio DataCore a livello mondiale, evidenziando al contempo i vantaggi e la value proposition di Parallel I/O, che libera la potenza e la produttività dell’elaborazione parallela per portare a prestazioni e tempi di risposta da record nello storage di applicazioni per database, analytics ed elaborazione transazionale in tempo reale.

“Sono lieto che una persona con il calibro e l’esperienza di Carrie si unisca al nostro team,” ha detto George Teixeira, President e CEO di DataCore. “Come azienda con oltre 10.000 implementazioni di successo, abbiamo la necessità di far conoscere i risultati che abbiamo ottenuto e raggiungere nuovi clienti per far crescere ancora il nostro core business. Strategicamente, dobbiamo trarre il massimo profitto dalla nostra innovativa tecnologia di elaborazione parallela e sfruttare le nuove opportunità che si presenteranno nel 2017. Il forte lavoro e la gestione di Carrie saranno determinanti per aiutare DataCore a rendere queste iniziative un successo".

Reber sarà responsabile delle attività di vendita e canale.Ben conosciuta come professionista di marketing e comunicazione nel settore della tecnologia, ha una vasta esperienza nella realizzazione e nella guida di strutture di marketing, nello sviluppo e nella gestione di piani strategici di posizionamento e comunicazione, nonché nel lancio di aziende software B2B innovative.

Con oltre 20 anni di esperienza nel settore tecnologico, Reber è stata recentemente vicepresidente di Datto con la responsabilità del marketing internazionale. In precedenza ha svolto funzioni dirigenziali in Infinio e ha realizzato la struttura di marketing gestendo le iniziative di go-to-market a supporto della rapida crescita di Veaam, partita come startup e arrivata a 100 milioni di dollari di fatturato.

Precedentemente, Reber è stata Director of Product Public Relations and Analyst Relations di Quest Software e ha lavorato in strutture di marketing di diverse aziende, tra cui Aelita Software, Legent Corp. e CompuServe.

Con la tecnologia Parallel I/O di DataCore che continua a ottenere risultati record nelle prestazioni e nel rapporto prezzo/prestazioni con le soluzioni Hyper-converged Virtual SAN e SANsymphony Software-Defined Storage, l’azienda ha registrato una crescita a doppia cifra in regioni chiave come le Americhe, l’EMEA e l’APAC.

Una delle principali responsabilità di Reber sarà quella di continuare a rafforzare la riconoscibilità del marchio DataCore a livello mondiale, evidenziando al contempo i vantaggi e la value proposition di Parallel I/O, che libera la potenza e la produttività dell’elaborazione parallela per portare a prestazioni e tempi di risposta da record nello storage di applicazioni per database, analytics ed elaborazione transazionale in tempo reale.

“Sono lieto che una persona con il calibro e l’esperienza di Carrie si unisca al nostro team,” ha detto George Teixeira, President e CEO di DataCore. “Come azienda con oltre 10.000 implementazioni di successo, abbiamo la necessità di far conoscere i risultati che abbiamo ottenuto e raggiungere nuovi clienti per far crescere ancora il nostro core business. Strategicamente, dobbiamo trarre il massimo profitto dalla nostra innovativa tecnologia di elaborazione parallela e sfruttare le nuove opportunità che si presenteranno nel 2017. Il forte lavoro e la gestione di Carrie saranno determinanti per aiutare DataCore a rendere queste iniziative un successo".